Dropout

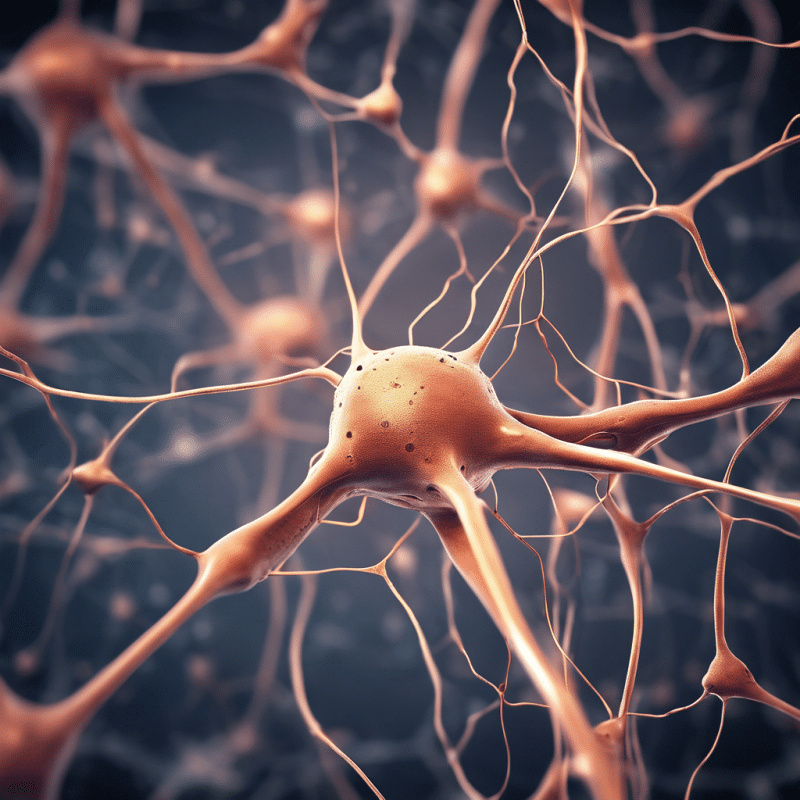

Es una técnica de regularización ampliamente utilizada en redes neuronales para prevenir el sobreajuste durante el entrenamiento del modelo.

Consiste en desactivar aleatoriamente un porcentaje de neuronas durante cada iteración del entrenamiento, lo que obliga a la red a aprender representaciones más robustas y generalizables.

Esta desactivación se aplica únicamente durante la fase de entrenamiento, mientras que en la fase de inferencia todas las neuronas permanecen activas.

El porcentaje de neuronas a desactivar se establece mediante un hiperparámetro conocido como tasa de Dropout, que generalmente se configura con un valor entre 0.2 y 0.5, dependiendo del problema a resolver.