Historia del desarrollo de la IA: Desde sus orígenes hasta el futuro que ya vivimos

Un recorrido completo y actualizado por la historia de la IA, desde sus orígenes filosóficos hasta las herramientas de IA generativa que están transformando industrias y estilos de vida.

La inteligencia artificial (IA) ha dejado de ser un concepto futurista para convertirse en una de las tecnologías más influyentes de nuestra era.

Su evolución, plagada de avances revolucionarios, periodos de estancamiento y renovadas esperanzas, ha marcado un camino fascinante que une ciencia, filosofía, matemáticas, computación y, cada vez más, nuestra vida cotidiana.

En este artículo para iartificial.blog, desentrañamos en profundidad la historia de la inteligencia artificial, analizando no solo sus etapas clave, sino también el impacto real que ha tenido en nuestra sociedad y lo que podemos esperar de su desarrollo en los próximos años.

- Primeras ideas: los inicios conceptuales de la inteligencia artificial

- La década de los 40 y 50: el nacimiento de la IA moderna

- Los primeros éxitos: optimismo y entusiasmo (1956–1970)

- Primer invierno de la IA: promesas incumplidas (1970–1980)

- La IA resurge: los sistemas expertos (1980–1990)

- Segundo invierno de la IA: nuevas dudas (finales de los 80–mediados de los 90)

- El despertar del machine learning (1990–2010)

- El auge del deep learning y la IA moderna (2010–2020)

- La IA generativa y el presente disruptivo (2020–2025)

- De la superinteligencia a la regulación: lo que viene

- ❓ Preguntas frecuentes sobre la historia de la inteligencia artificial

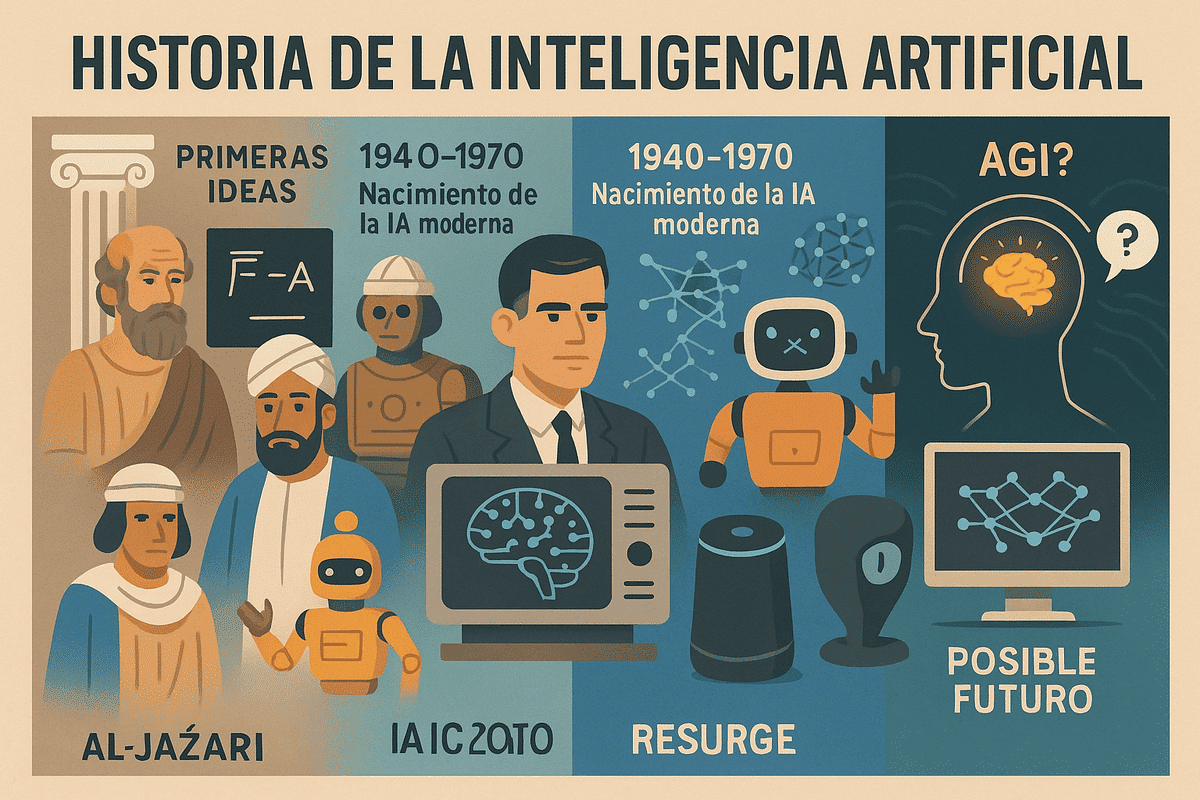

Primeras ideas: los inicios conceptuales de la inteligencia artificial

Aunque la IA parece un fenómeno reciente, sus raíces teóricas se remontan a la Antigüedad clásica. Diversos pensadores ya fantaseaban con la posibilidad de construir autómatas, es decir, máquinas con comportamiento inteligente.

En la Grecia antigua, figuras como Aristóteles reflexionaron sobre sistemas de razonamiento lógico que más tarde serían fundamentales en el desarrollo de la lógica computacional.

Por su parte, en el mundo islámico medieval, inventores como Al-Jazari diseñaron mecanismos automáticos que se consideran los precursores de la automatización.

Más adelante, durante el Renacimiento y la Ilustración, la idea de que la mente humana podía entenderse como una máquina fue ganando terreno.

Sin embargo, no fue hasta el siglo XX cuando estas ideas empezaron a materializarse con fundamentos científicos.

La década de los 40 y 50: el nacimiento de la IA moderna

El siglo XX trajo consigo avances tecnológicos sin precedentes. La invención del computador digital y el desarrollo de la lógica matemática crearon el entorno propicio para la aparición de la IA moderna.

Uno de los momentos clave fue la publicación, en 1950, del influyente artículo de Alan Turing, "Computing Machinery and Intelligence". En él, el matemático británico planteaba la célebre pregunta: ¿pueden las máquinas pensar? y proponía lo que hoy conocemos como el Test de Turing como método para evaluar la inteligencia de una máquina.

Simultáneamente, científicos como John von Neumann, Claude Shannon y Norbert Wiener exploraban la computación, la teoría de la información y la cibernética, aportando bases cruciales para lo que vendría después.

Pero fue en 1956, durante la legendaria conferencia de Dartmouth College, donde nació oficialmente el campo de la inteligencia artificial como disciplina académica. Liderado por John McCarthy, quien acuñó el término "artificial intelligence", este evento reunió a pioneros como Marvin Minsky, Allen Newell y Herbert Simon, todos convencidos de que pronto las máquinas alcanzarían niveles humanos de inteligencia.

Los primeros éxitos: optimismo y entusiasmo (1956–1970)

Durante los primeros años, los investigadores lograron desarrollar programas capaces de ejecutar tareas aparentemente "inteligentes".

Uno de los más conocidos fue Logic Theorist, creado por Newell y Simon, que podía demostrar teoremas matemáticos.

Otro fue ELIZA, un programa de procesamiento de lenguaje natural que simulaba un psicoterapeuta.

Estos primeros logros generaron un entusiasmo desmedido. Se llegó a afirmar que en menos de una década las máquinas superarían la inteligencia humana. Sin embargo, los investigadores pronto chocaron con la complejidad del mundo real.

Primer invierno de la IA: promesas incumplidas (1970–1980)

Las expectativas fueron demasiado altas. A medida que los sistemas fallaban en tareas más complejas, los gobiernos y financiadores comenzaron a retirar el apoyo económico. Este período de desencanto se conoce como el primer invierno de la IA.

Los principales problemas eran:

- Falta de datos y poder computacional limitado.

- Incapacidad de los sistemas para aprender por sí solos.

- Problemas con el lenguaje natural y el sentido común.

La IA simbólica, basada en reglas lógicas explícitas, se mostró insuficiente para abordar problemas reales. A pesar de ello, en el ámbito académico se siguieron desarrollando teorías que más tarde serían útiles, como los primeros modelos de redes neuronales.

La IA resurge: los sistemas expertos (1980–1990)

A comienzos de los años 80, la inteligencia artificial volvió a captar la atención con el auge de los sistemas expertos. Estos eran programas diseñados para emular el conocimiento de un experto humano en un dominio específico, como la medicina o la geología.

Ejemplos notables:

- MYCIN, un sistema para diagnosticar infecciones sanguíneas.

- XCON, que ayudaba a configurar sistemas de computación en DEC.

Aunque estos sistemas funcionaban bien en contextos limitados, su dependencia de reglas rígidas volvió a mostrar limitaciones ante situaciones nuevas o ambiguas. Con el tiempo, su mantenimiento se volvió costoso y poco escalable, y la industria volvió a perder interés.

Segundo invierno de la IA: nuevas dudas (finales de los 80–mediados de los 90)

El segundo invierno de la IA surgió cuando quedó claro que los sistemas expertos no podrían generalizar el conocimiento ni adaptarse a situaciones fuera de su programación.

Además, mientras la IA decepcionaba, otras áreas como el software tradicional y la computación distribuida avanzaban a gran velocidad, acaparando la atención de la industria.

Aun así, en los laboratorios, se sembraban las semillas de lo que sería una nueva revolución. Investigadores empezaban a explorar enfoques alternativos: el aprendizaje automático y las redes neuronales profundas.

El despertar del machine learning (1990–2010)

Durante esta etapa, la inteligencia artificial vivió una transformación conceptual. Se pasó de intentar programar la inteligencia a permitir que las máquinas aprendieran de los datos.

Esta es la base del aprendizaje automático (machine learning).

El desarrollo de algoritmos como los árboles de decisión, los SVM (máquinas de vectores de soporte) y los métodos de ensamble permitió avances significativos en tareas de clasificación, predicción y análisis de datos.

Otro hito fue el triunfo de IBM Deep Blue sobre el campeón mundial de ajedrez Garry Kasparov en 1997.

Aunque Deep Blue no "pensaba", su capacidad para evaluar millones de movimientos por segundo supuso un antes y un después.

Simultáneamente, comenzaba a popularizarse Internet, lo que generó una avalancha de datos disponibles para el entrenamiento de modelos. La conjunción de más datos, mejores algoritmos y mayor poder computacional sentó las bases de la revolución que se avecinaba.

El auge del deep learning y la IA moderna (2010–2020)

La década de 2010 marcó la explosión definitiva de la IA gracias al aprendizaje profundo (deep learning). Basado en redes neuronales artificiales con múltiples capas, el deep learning demostró una capacidad sin precedentes para reconocer patrones complejos.

Uno de los grandes hitos fue AlexNet, una red neuronal que en 2012 arrasó en el concurso de visión por computadora ImageNet, reduciendo drásticamente el error de clasificación de imágenes. A partir de ahí, empresas como Google, Facebook y Microsoft comenzaron a invertir masivamente en IA.

Tecnologías revolucionarias surgieron de esta etapa:

- Reconocimiento facial.

- Traducción automática neuronal.

- asistentes virtuales inteligentes como Siri, Alexa y Google Assistant.

- Modelos generativos como los primeros GPT de OpenAI.

La IA empezó a integrarse en el día a día de las personas, desde recomendaciones de Netflix hasta diagnósticos médicos asistidos por IA.

La IA generativa y el presente disruptivo (2020–2025)

Estamos viviendo una nueva etapa que ha sorprendido incluso a los más optimistas: la era de la IA generativa. Esta tecnología no solo procesa información, sino que crea contenido original, desde textos hasta imágenes, música o código.

Herramientas como GPT-3, GPT-4, DALL·E, Stable Diffusion o Midjourney han democratizado el acceso a capacidades creativas automatizadas. Ya no se trata solo de automatizar tareas, sino de reimaginar la creatividad con ayuda de algoritmos.

Al mismo tiempo, surgen debates éticos profundos:

- ¿Qué pasa con los derechos de autor en contenidos generados por IA?

- ¿Cómo se regulan los sesgos algorítmicos?

- ¿Estamos creando inteligencias opacas que ni sus propios diseñadores entienden?

Además, la aparición de copilotos de código o asistentes de productividad con IA integrada está transformando radicalmente sectores como la programación, el diseño o el marketing.

De la superinteligencia a la regulación: lo que viene

Hoy, los principales debates sobre el futuro de la inteligencia artificial giran en torno a temas como:

- La AGI (inteligencia artificial general): ¿puede una IA llegar a igualar o superar todas las capacidades humanas?

- El impacto en el empleo: ¿destruirá trabajos o los transformará?

- El uso militar y la autonomía de sistemas letales.

- La gobernanza global de la IA: ¿quién debe regular estas tecnologías?

Empresas líderes como OpenAI, DeepMind y Anthropic ya trabajan en modelos cada vez más potentes, mientras gobiernos de todo el mundo buscan crear marcos regulatorios que garanticen un desarrollo seguro y ético.

En definitiva, la historia de la inteligencia artificial no es solo una cronología de avances técnicos, sino un reflejo de cómo la humanidad ha intentado replicar, entender y superar su propia inteligencia.

Desde los autómatas de la antigüedad hasta los modelos generativos actuales, el viaje de la IA ha estado marcado por sueños, fracasos, logros y dilemas éticos que continúan evolucionando.

En iartificial.blog creemos que es vital comprender este recorrido para afrontar con responsabilidad y criterio los retos del presente. Porque la IA ya no es una promesa del futuro: es el presente que nos exige estar informados, preparados y conscientes de su potencial transformador.

❓ Preguntas frecuentes sobre la historia de la inteligencia artificial

1. ¿Quién inventó la inteligencia artificial?

La inteligencia artificial no fue inventada por una sola persona, sino que es el resultado del trabajo conjunto de muchos científicos.

Sin embargo, se considera que John McCarthy fue quien acuñó el término "inteligencia artificial" en 1956, durante la conferencia de Dartmouth. Otros pioneros clave incluyen a Alan Turing, Marvin Minsky y Herbert Simon.

2. ¿Cuáles han sido los principales hitos en la evolución de la IA?

Algunos hitos destacados son:

- El Test de Turing propuesto en 1950.

- La creación del primer programa de IA en 1956.

- La victoria de Deep Blue sobre Kasparov en 1997.

- El auge del aprendizaje profundo con AlexNet en 2012.

- El surgimiento de modelos generativos como GPT-3 y DALL·E a partir de 2020.

3. ¿Qué diferencia hay entre IA, machine learning y deep learning?

- IA (inteligencia artificial) es el campo general que busca que las máquinas realicen tareas que requieren inteligencia humana.

- Machine learning (aprendizaje automático) es una subrama de la IA que permite a las máquinas aprender de datos sin ser programadas explícitamente.

- Deep learning (aprendizaje profundo) es un tipo avanzado de machine learning que utiliza redes neuronales con muchas capas para procesar grandes volúmenes de datos de forma muy eficiente.